L'IA est-elle suffisamment intelligente pour aider les communautés vulnérables ?

Développer l'IA pour favoriser le développement

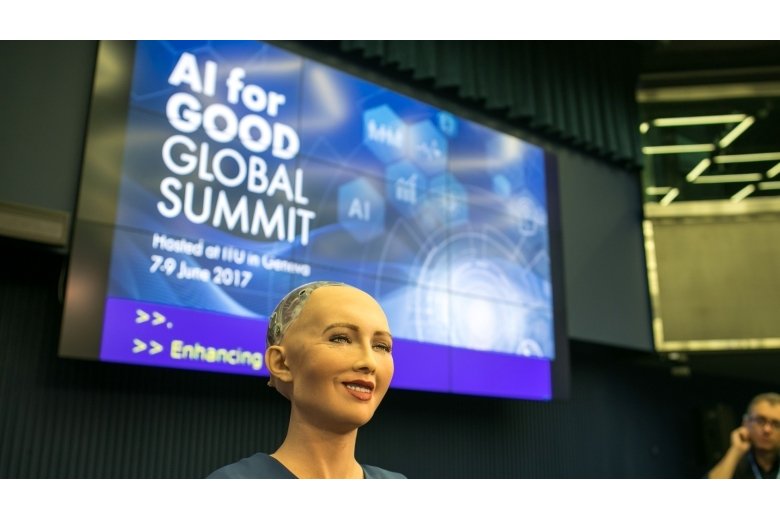

Sophia, Hanson Robotics Ltd., speaking at the AI for Good Global Summit, ITU, Geneva, Switzerland, June 7-9, 2017. © ITU/R.Farrell

Rabi Thapa

Fin 2022, le lancement de ChatGPT, le chatbot d'intelligence artificielle (IA) générative d'OpenAI, a déclenché une tempête médiatique à propos de l'évolution galopante de l'IA et de ce que cela laisse présager pour l'espèce humaine et pour toute la planète. Lors du tout récent Sommet mondial du numérique, le président de la Banque mondiale, Ajay Banga, a souligné que « même les gens peu au fait de l'IA se ruent vers cette technologie, de peur d'être dépassés. »

L'IA n'est pas une nouveauté, car elle est déjà utilisée dans de nombreux secteurs du développement. Elle a toutefois connu une évolution spectaculaire, en passant de systèmes basés sur des règles du type « si X, alors Y » à des systèmes d'apprentissage automatique « profonds » qui imitent les réseaux neuronaux humains. Le débat sur les avantages et les inconvénients de l'IA a accéléré l'élaboration de réglementations pour régir son utilisation, et les conférences sur les nouvelles technologies se sont multipliées.

Alors qu'il nous semble que l'IA est partout, la fracture numérique est pourtant bien réelle et il convient de tirer le signal d'alarme. Près de la moitié de la population mondiale n'a pas accès à internet et environ 800 millions de personnes n'ont pas l'électricité, principalement dans les régions où se concentrent les efforts de développement. Compte tenu du rythme de l'innovation et de la diffusion de l'IA dans le Nord global, il est probable que la « fracture de l'IA » soit encore plus marquée dans les pays où les fondements d'une économie numérique n'existent pas. Mais alors, quelle est la place de l'IA dans le domaine du développement et comment cela affecte-t-il les communautés vulnérables susceptibles d'être pénalisées par les projets de développement ?

Vers quoi sommes-nous en train de nous ruer ?

Il ne fait aucun doute que l'IA est un phénomène majeur : un rapport de 2017 de PwC Global estime qu'elle pourrait injecter 15 700 milliards de dollars dans l'économie mondiale d'ici 2030. Mais à qui profiterait cette manne, et que signifie la révolution de l'IA pour l'Agenda 2030 ? En fait, l'IA est considérée par beaucoup comme essentielle à la réalisation des Objectifs de développement durable (ODD), auxquels correspond le double objectif du Groupe de la Banque mondiale de mettre fin à l'extrême pauvreté et de favoriser une prospérité partagée.

À l'occasion du lancement de l’Organe consultatif de haut niveau sur l'intelligence artificielle des Nations Unies, en octobre 2023, le secrétaire général António Guterres a déclaré que l'IA pourrait « booster » les avancées vers la réalisation des ODD. Une étude menée par l'Institut royal de technologie (KTH), en Suède, a révélé que l'IA, en facilitant la prise de décision, la prédiction, l'extraction de connaissances et la reconnaissance de formes ainsi que le raisonnement logique, pourrait contribuer à la réalisation de 134 des 169 cibles des 17 ODD. L'agriculture de précision, les diagnostics médicaux, le soutien aux enseignants et le tutorat virtuel, ainsi que l'utilisation efficace de l'eau et de l'énergie sont autant d'exemples de bénéfices avérés de l'IA.

De nombreux projets financés par la Banque mondiale mettent en évidence les avantages de l'IA pour les populations pauvres. Par exemple, pendant la pandémie de COVID-19, la cartographie, l'analyse géospatiale et l'apprentissage automatique ont permis d'évaluer l'accessibilité des bénéficiaires aux services de protection sociale en Tunisie. Au Pakistan, la Banque mondiale a utilisé l'IA pour créer des prototypes et développer des algorithmes afin d'améliorer la gestion des prêts au logement pour les familles travaillant dans le secteur informel. L'IA a également été utilisée au Nigéria pour renforcer le suivi des travaux publics et l'engagement des citoyens en évaluant les réponses envoyées par téléphonie mobile, à l'aide de nuages de mots-clés, d'exploration d'opinion et d'analyseurs de sentiments.

Rattraper le retard

L'émergence d'une fracture de l'IA est préoccupante. Stela Mocan, directrice du Laboratoire de technologie et d'innovation de la Banque mondiale et qui a participé aux projets d'IA au Pakistan et en Tunisie, déclare : « Nos pays clients s'intéressent de plus en plus à l'exploitation des technologies d'IA, mais nous devons déterminer précisément s'ils y sont prêts, en termes de données, d'infrastructures, de compétences, de niveaux de numérisation et de cadres juridiques et politiques. Comment pourrait-on mettre en œuvre un projet d'IA à partir d'une page blanche ? »

Au-delà de l'inquiétude croissante concernant les risques de l'IA en matière de cybersécurité, de désinformation, de protection de la vie privée, de droits d'auteur, d'éthique et d'emploi, la question se pose également de savoir si les outils principalement développés dans le Nord global sont adaptés aux pays en développement. La qualité de l'IA dépend des données qui lui sont fournies. Les algorithmes formés à partir de reportages qui contiennent des préjugés à l'encontre des femmes et des filles les reproduiront et pourraient entraver la réalisation de l'ODD 5 sur l'égalité des sexes. Et ce type de risque s'applique à toutes les communautés vulnérables et marginalisées. Le rapport du KTH constate que 59 cibles des ODD pourraient être compromises par les nouvelles technologies. Par exemple, les équipements agricoles améliorés par l'IA pourraient ne pas être accessibles aux petits paysans des pays en développement, ce qui aurait un impact négatif sur l'ODD 2 relatif à l'élimination de la faim.

Aux Philippines, Maya Villaluz, ingénieure senior en environnement qui utilise des techniques de cartographie et de géolocalisation assistées par l'IA pour un important programme agro-industriel, met en garde contre une approche uniforme : « Le Cadre environnemental et social de la Banque mondiale exige que des évaluations spécifiques au site et des études environnementales et sociales soient effectuées pour chaque activité des sous-projets. Cela crée une demande d'analyses qui peuvent être facilitées par l'IA. Cependant, pour déterminer les besoins réels des habitants d'un pays en développement, il faut comprendre la diversité de leurs écosystèmes. Si aucune étude n'a été menée et qu'il n'y a pas de données de base, il est important de s'appuyer sur un jugement professionnel afin de vérifier et de valider les données utiles à partir d'un magma d'informations aléatoires et sans rapport entre elles. »

L'IA au service de la redevabilité : quel potentiel ?

Comment l'IA peut-elle aider les mécanismes de redevabilité indépendants à atteindre les communautés ? Esteban Tovar Cornejo, spécialiste des questions sociales et environnementales au Mécanisme indépendant de consultation et d'enquête (MICI) de la Banque interaméricaine de développement (BID), explique comment la BID a adopté l'IA en s'associant à Microsoft pour optimiser l'utilisation de son chatbot, Co-Pilot. La rédaction des contrats de travail des nouveaux embauchés, en quatre langues, a été la première tâche confiée à l'IA et cela a permis de gagner du temps. M. Cornejo et son équipe testent aussi des instructions pour l'IA qui aideront la MICI à présenter leurs conclusions aux parties prenantes : « Nous pouvons demander à l'outil d'IA d'imaginer qu'un chef d'équipe projet de la BID a reçu une plainte. Quelles sont les informations qui lui seront alors utiles ? Nous pouvons attribuer différents rôles dans différents secteurs afin de mieux comprendre comment travailler avec la direction de la BID, la société civile ou les populations autochtones. » À l'avenir, les parties prenantes externes pourront utiliser l'IA pour poser les mêmes questions afin d'être mieux informées sur les affaires traitées, éventuellement grâce à une application téléphonique dédiée du MICI.

La difficulté consiste à poser les bonnes questions et à exploiter les bonnes données. À cet égard, l'approche progressive de la BID en matière d'IA, qui s'appuie sur ses travaux en matière d’accès aux données, est un point de départ pour le MICI, mais la nécessité de garantir des données de qualité constante signifie que l'équipe du MICI se concentre principalement sur l'innovation et l'efficacité internes. Plusieurs autres dispositifs contactés par Accountability Matters ont indiqué que, bien que des travaux exploratoires sur l'IA soient en cours, il était prématuré d'en partager les résultats.

Les modèles de traitement du langage naturel peuvent offrir plusieurs options aux mécanismes de redevabilité. Les entreprises emploient depuis longtemps des chatbots automatisés pour le traitement des plaintes sur une grande échelle. L'automatisation peut se limiter au dépôt des plaintes et à l'accusé de réception, mais l'IA peut aussi rechercher des mots-clés et analyser le contenu émotionnel des réclamations. Elle peut alors décider si une plainte donnée doit être transmise à un interlocuteur humain. Pour les dispositifs qui reçoivent des plaintes complexes sur l'impact des projets, ce mode d'utilisation de l'IA comporte des risques et n'est peut-être même pas nécessaire étant donné le nombre relativement faible de plaintes reçues. Néanmoins, les chatbots conversationnels, assistés par l'IA, pourraient soutenir l'action des mécanismes de redevabilité en orientant les plaignants vers les pages pertinentes des sites web, que ce soit pour enregistrer une plainte ou pour s'informer sur des affaires spécifiques.

Les capacités de synthèse de l'IA s'améliorent rapidement elles aussi et des recherches récentes suggèrent que plus de 50 % des évaluateurs préfèrent les résumés de l'IA à ceux produits par des humains. Associées à des traductions multilingues instantanées générées par l'IA et à des visuels qui simplifient les données complexes pour les profanes, les synthèses pourraient aider les membres des communautés à accéder au contenu des documents techniques produits par les mécanismes de redevabilité. De leur côté, ces mécanismes pourraient utiliser l'IA pour résumer les notes et les enregistrements audio des visites sur le terrain grâce à des dispositifs permettant d'économiser du temps et de la main-d'œuvre tout en favorisant la transparence et l'accessibilité. Il convient toutefois d'être prudent quant à l'utilisation d'outils développés dans le Nord global, car ils peuvent avoir des difficultés à saisir la complexité des dynamiques sociales propres aux différentes affaires.

Megumi Tsutsui, chercheuse senior associée chez Accountability Counsel, reconnaît les difficultés liées aux données qu'implique l'utilisation de l'IA pour cerner les risques et les préoccupations environnementales, sociales et de gouvernance (ESG), comme a commencé à le faire IFC avec MALENA, son outil d'analyse basé sur l'apprentissage automatique. Elle espère néanmoins que l'IA « fera gagner du temps, réduira les coûts et améliorera l'efficacité, ce qui permettra de faire preuve d'une plus grande diligence raisonnable et d'obtenir davantage d'informations de la part des personnes qui sont les plus touchées sur le terrain par ces grands projets. »

Un volet important de cette diligence améliorée consiste à s'assurer que les données utilisées sont fiables et que les préoccupations des populations locales ne sont pas ignorées. « Les personnes touchées par ces projets ne génèrent pas de données qu'un modèle d'IA pourrait capturer », souligne Mme Tsutsui. « Nous devons donc nous assurer que nous vérifions les informations fournies par les communautés. Leurs avis doivent être pris en compte d'une manière ou d'une autre. »

La puissance analytique de l'IA peut toutefois se révéler utile dans le contexte d'ensembles de données plus vastes et plus complexes. À l'instar des mécanismes de redevabilité dont Accountability Counsel suit le travail dans les communautés du monde entier, Megumi Tsutsui explique que son organisation aborde l'IA avec une prudence légitime. Cependant, il est déjà prévu d'utiliser l'IA pour Accountability Console, la base de données gérée par Accountability Counsel et qui rassemble près de 1 800 plaintes, et pour l'analyse comparative des politiques qui sous-tend les rapports phares sur les politiques de redevabilité, tels que le Good Policy Paper. « La comparaison et l'analyse comparative sont des processus très manuels », explique aussi Mme Tsutsui. « Nous espérons qu'avec l'IA, ce sera beaucoup plus rapide et que nous pourrons alors nous concentrer sur l'approfondissement des analyses. »

Un billet de blog du pôle Développement numérique de la Banque mondiale décompose la prise de décision en deux temps : « prédire les résultats et décider des actions à entreprendre ». L'une des caractéristiques de l'IA est qu'elle dissocie la prédiction du jugement. Au final, nous conservons le pouvoir de porter des jugements humains. Si l'IA s'améliore dans la prédiction, alors les humains ont la possibilité de s'améliorer dans le jugement. Comme le fait remarquer Alexandra Todericiu, responsable des technologies de l'information au sein du Laboratoire de technologie et d'innovation, « tout le monde craint que l'IA nous remplace, mais le débat devrait plutôt porter sur la manière dont l'IA peut nous aider à être plus efficaces. »

Trouver un équilibre entre espoirs et craintes grâce à la gouvernance

Depuis 2018, le Groupe de la Banque mondiale a lancé environ 45 projets liés à l'IA, notamment des innovations comme MALENA et Mai, le chatbot sécurisé de la Banque mondiale alimenté par l'IA. Un cadre de gouvernance de l'IA est à l'étude. Bien des institutions internationales et de nombreux gouvernements ont rédigé des réglementations sur l'IA, comme les États-Unis, la Chine, les Nations Unies et l'Union européenne. Leurs objectifs généraux sont similaires en ce sens qu'ils visent à garantir une IA responsable, conforme aux normes éthiques, respectueuse des droits humains et limitant les risques et les préjudices. Mais les approches varient considérablement entre les orientations « douces », les lois « dures » et « l'autoréglementation » qui fait porter la responsabilité sur l'industrie de l'IA.

Certains ne sont pas convaincus que nous en fassions assez. Michael Møller, membre du conseil d'administration du Geneva Science and Diplomacy Anticipator (GESDA) et ancien sous-secrétaire général des Nations Unies, déclare ainsi : « Presque tout le monde court après un cheval qui s'est déjà emballé. Nous envisageons l'IA telle que nous la connaissons aujourd'hui, mais c'est un jeu d'enfant comparé à l'accélération vertigineuse qui nous attend. Nous ne consacrons pas assez de réflexion et d'efforts aux technologies de demain : la gouvernance, l'éthique, les questions d'équité, la redevabilité, la transparence, etc. doivent être intégrées aux technologies de l'IA avant que celles-ci sortent des laboratoires et des universités. Il y a beaucoup de choses à revoir en ce moment en ce qui concerne les lignes directrices sur la manière de gouverner l'IA. Le problème est que personne ne relie les différents points entre eux et que personne ne se parle vraiment. Ce dont nous avons vraiment besoin, c'est d'un ensemble de règles souples et globales sur lesquelles tout le monde puisse s'entendre. »

Lors d'une visite en février 2024 dans la Silicon Valley californienne, Volker Türk, le haut-commissaire des Nations Unies aux droits de l'homme, s'est fait l'écho du plaidoyer de Michael Møller en faveur d'une « innovation encadrée » pour l'IA. Critiquant les développeurs pour leur manque de « vision globale du monde », M. Türk a appelé l'industrie technologique à adhérer aux Principes directeurs des Nations Unies relatifs aux entreprises et aux droits de l'homme : « Il faut que les entreprises adoptent une conduite responsable. Nous devons appliquer le principe de responsabilité en cas de préjudice. Les victimes de tels préjudices doivent pouvoir accéder à des voies de recours. Mais avant tout, pour éviter que ces préjudices ne se produisent, nous avons besoin d’une bonne gouvernance de l’IA, fermement ancrée dans les droits de l’homme. »

Il se peut que nous devions simplement nous parler davantage. Michael Møller explique comment le GESDA facilite les échanges : « Nous mettons en contact des scientifiques avec des non-scientifiques afin que ces deux groupes, qui ne se sont jamais vraiment parlé auparavant, puissent mieux se comprendre. Il ne s'agit pas d'une simple conversation, mais d'une manière de créer des groupes de travail communs aux scientifiques et aux non-scientifiques. Et ces échanges ont eu un impact sur de nombreux scientifiques de haut niveau qui ont soudain pris conscience du fait qu'ils doivent intégrer une compréhension de l'impact potentiel sur la société des sujets sur lesquels ils travaillent. »

Khuram Farooq, spécialiste senior de la gouvernance à la Banque mondiale, résume bien le défi que représente l'application responsable de l'IA au développement : « Souvent, les gens imaginent la technologie, puis essaient d'adapter l'outil aux problèmes du monde réel. Mais il ne faut jamais commencer par la technologie. Si quelqu'un veut obtenir un permis de conduire, il ne se soucie pas de savoir s'il est assisté par l'IA ou s'il s'agit simplement d'un morceau de papier : la personne veut simplement obtenir rapidement son permis. Il faut commencer par le problème, puis se demander si l'IA peut aider à le résoudre. » À l'approche du sommet mondial AI for Good organisé par les Nations Unies en mai prochain, le slogan « Connecter les innovateurs de l'IA à ceux qui gèrent les problèmes pour résoudre les défis mondiaux » n'a jamais semblé aussi pertinent.